dungnh

Intern

Thực hiện cấu hình HA cho NSX Manager

Tài liệu này sẽ hướng dẫn cấu hình HA cho NSX Manager1. Kiến trúc Cluster 3 Node

Để đảm bảo tính sẵn sàng cao, VMware yêu cầu triển khai một cụm gồm 3 node NSX Manager cho môi trường Production.- Cơ sở dữ liệu phân tán (Corfu DB): Cả 3 node này chạy trên một nền tảng dữ liệu phân tán gọi là Corfu. Mọi thay đổi cấu hình bạn thực hiện trên một node sẽ được đồng bộ hóa tức thời (synchronous replication) sang 2 node còn lại.

- Yêu cầu độ trễ (Latency): Do việc đồng bộ diễn ra liên tục và tức thời, độ trễ mạng giữa các node NSX Manager trong cụm không được vượt quá 10ms.

2. Cơ chế hoạt động của HA (Nguyên tắc Quorum)

Khả năng hoạt động của NSX Manager dựa trên nguyên tắc Quorum.- Điều kiện hoạt động: Để cụm hoạt động bình thường và cho phép ghi dữ liệu (thêm/sửa/xóa cấu hình), phải có ít nhất 2 trên 3 node đang hoạt động.

- Kịch bản 1 Node chết: Nếu 1 node bị hỏng, 2 node còn lại vẫn duy trì được Quorum. Hệ thống vẫn hoạt động bình thường, bạn vẫn có thể đăng nhập, cấu hình mạng và Control Plane vẫn ổn định.

- Kịch bản 2 Node chết (Mất Quorum): Nếu 2 node bị hỏng cùng lúc hoặc mất kết nối, cụm sẽ mất Quorum. Lúc này:

- NSX Manager sẽ bị vô hiệu hóa hoặc chuyển sang chế độ Read-Only (chỉ đọc).

- Không thể thực hiện vc thêm cấu hình mới,...

- Tuy nhiên ác máy ảo vẫn gửi nhận dữ liệu được vì Data Plane nằm trên các ESXi Host và Edge Node, hoạt động độc lập với Manager

3. Cách truy cập Cluster (VIP or Load Balancer)

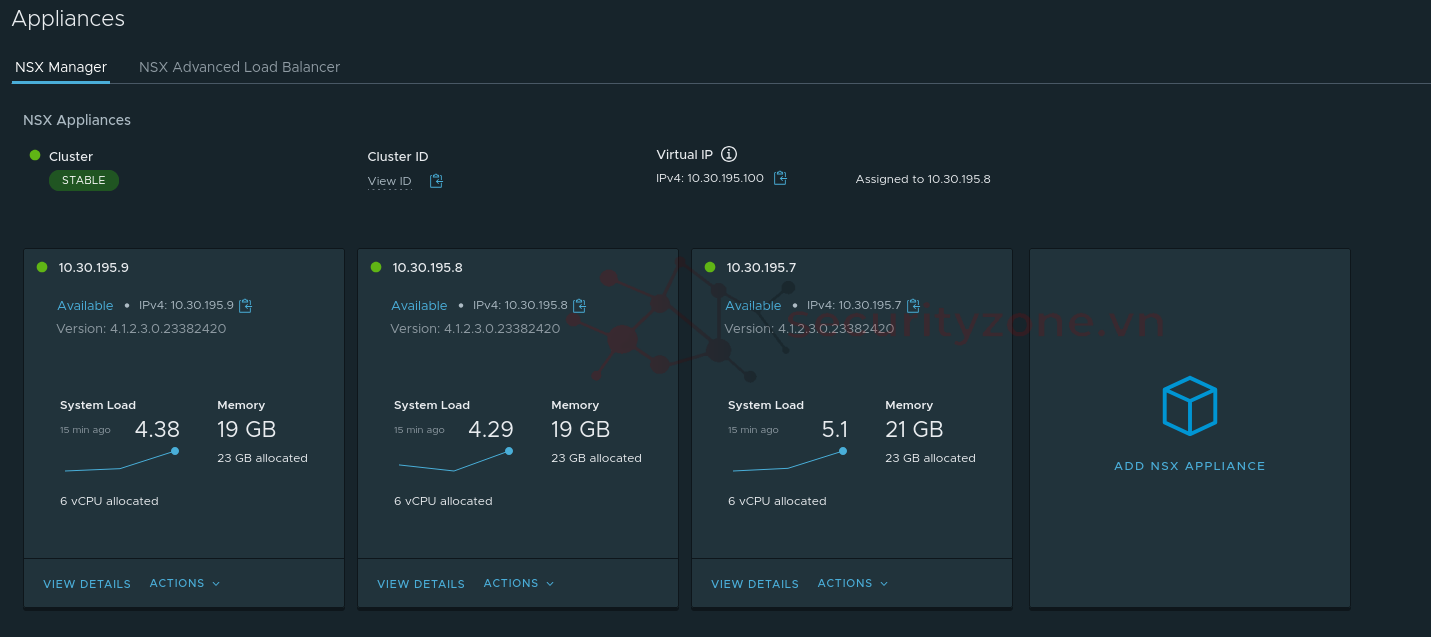

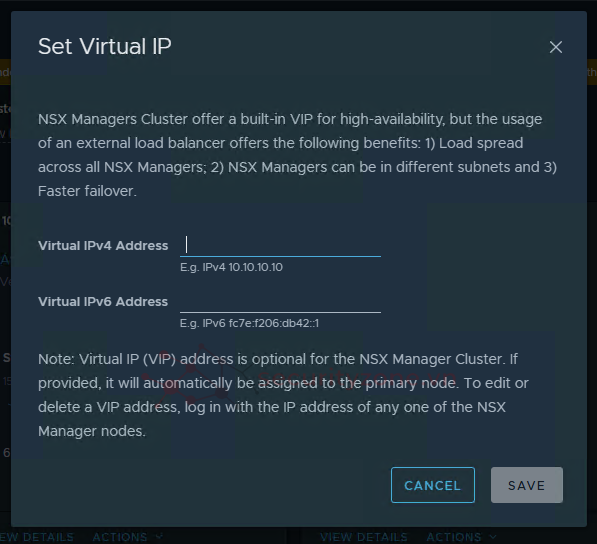

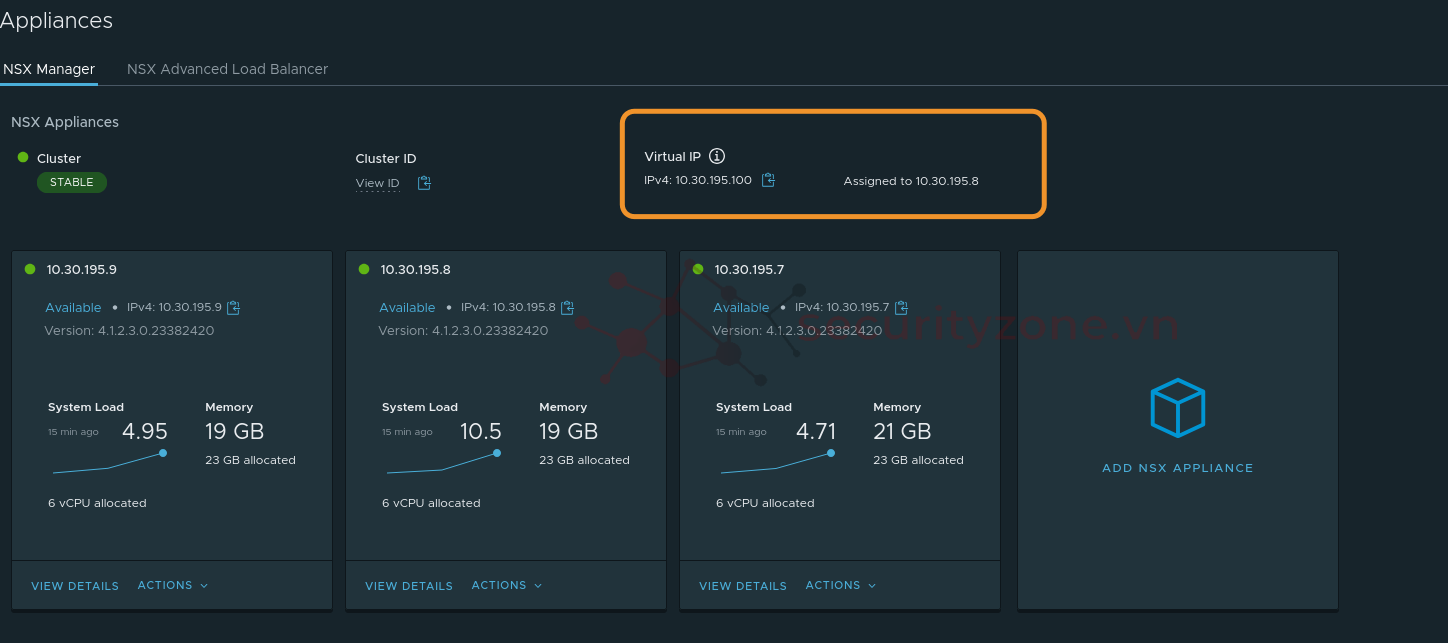

Để quản trị Cluster hoặc truy cập vào thì có 2 cách chính là- Virtual IP (VIP) : Cấu hình một địa chỉ IP ảo (VIP) chung cho cả cụm. Tại một thời điểm, VIP này chỉ được gán cho một node duy nhất đóng vai trò là Leader

- Cơ chế Failover: Nếu node Leader bị chết, các node còn lại sẽ bầu ra một Leader mới và Leader mới sẽ nhận lấy VIP này. Quá trình chuyển đổi có thể mất vài phút (khoảng 1-3 phút)

- Hạn chế: Tất cả 3 node NSX Manager bắt buộc phải nằm trong cùng một subnet. Nó không thực hiện cân bằng tải thực sự mà chỉ là cơ chế Active-Standby cho địa chỉ IP quản lý.

- NSX Advanced Load Balancer (Avi) : Load Balancer sẽ nhận yêu cầu và phân phối đều cho cả 3 node NSX Manager (Active-Active)

- Cho phép các node NSX Manager nằm ở các subnet khác nhau (ví dụ trải dài trên các Rack hoặc L3 domain khác nhau để an toàn hơn)

- Thời gian phát hiện lỗi và chuyển hướng nhanh hơn so với VIP.

- Hiệu năng tốt hơn do tận dụng được cả 3 node để xử lý API.

4. Cấu hình Cluster NSX Manager

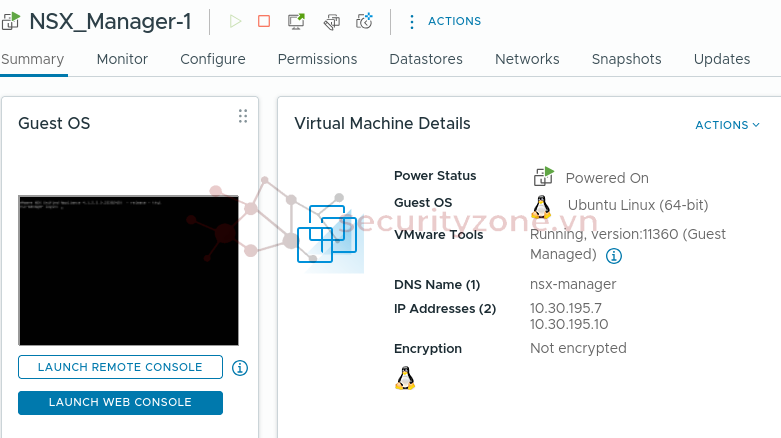

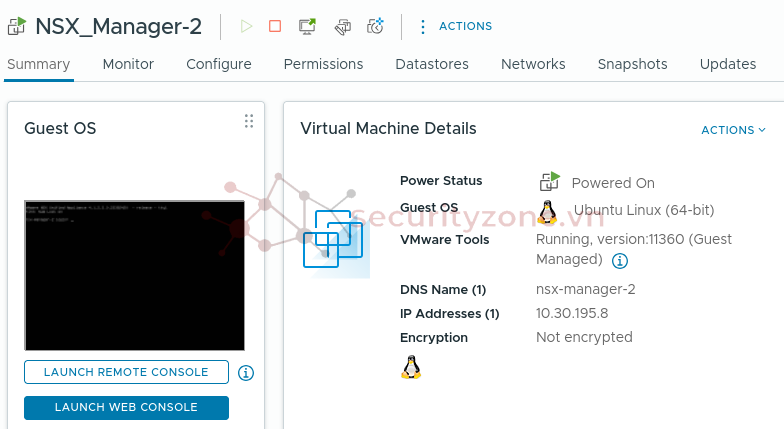

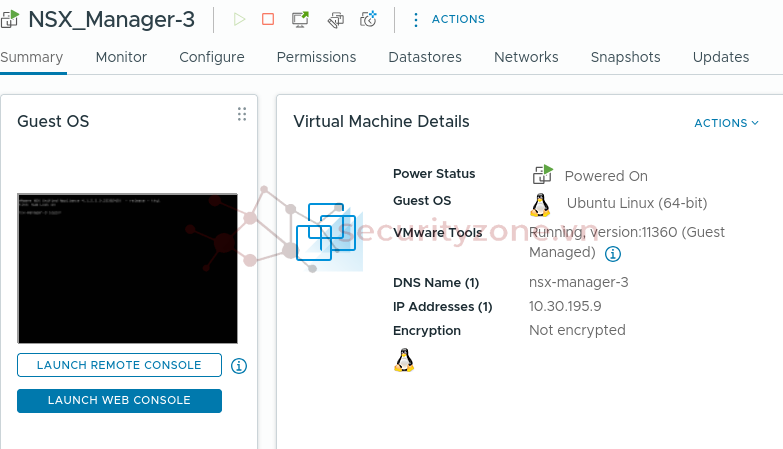

Để triển khai được một cụm Cluster NSX Manager, chúng ta cần thêm 2 node nửa, ta tiến hành tạo như đã trình bày ở Lab 2 Cấu hình cơ bản.

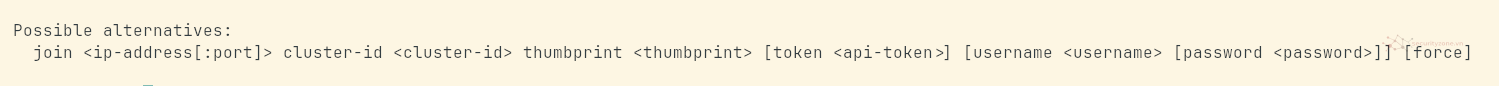

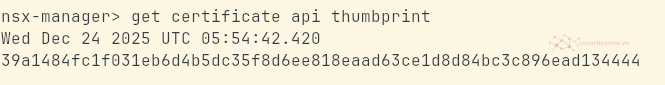

Tiến hành join NSX Manager vào cluster : Ta có câu lệnh join như ở bên dưới dùng để join node hiện tại vào một node chỉ định bằng cluster-id cùng với thumbprint để tạo thành cụm cluster.

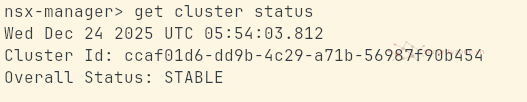

Đầu tiên ta phải tiến hành lấy cluster-id của node đã được chỉ định làm primary

Ta tiếp tục đặt VIP

Đính kèm

Bài viết liên quan

Được quan tâm

Bài viết mới